Achtergrond

Kun je bewijzen dat een foto echt is?

van David Lee

Of een afbeelding, tekst of video is gemaakt met behulp van kunstmatige intelligentie (AI) moet transparant worden gemaakt. Maar dit is nog niet zo eenvoudig. Instagram is het meest recente voorbeeld hiervan, maar ook alle andere pogingen zijn tot nu toe jammerlijk mislukt.

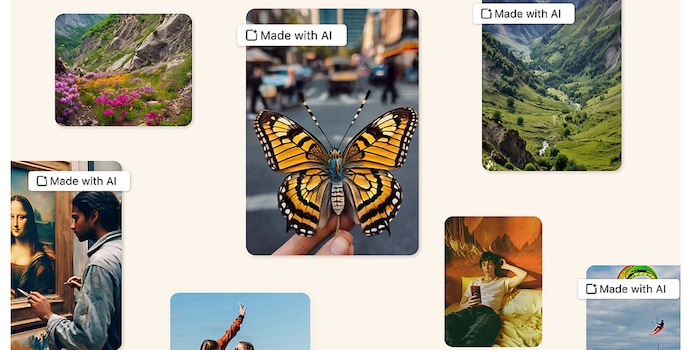

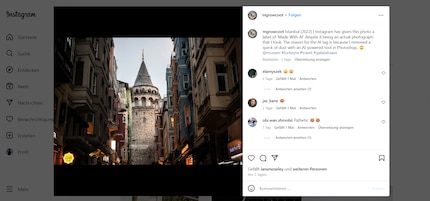

Transparantie is belangrijk als het gaat om AI-gegenereerde content. Meta, het bedrijf achter Facebook en Instagram, wil AI-gegenereerde afbeeldingen als zodanig labelen zodat niemand voor de gek wordt gehouden. Sinds mei 2024 worden sommige afbeeldingen op Instagram als zodanig gelabeld: Je ziet dan een opmerking "Made with AI". In ieder geval in de VS. Ik heb zelf nog geen dergelijke markeringen gezien. In Europa lijken ze nog niet actief te zijn.

De bezorgdheid is prijzenswaardig. Er is alleen één klein probleem: het werkt niet. Volgens verschillende rapporten, tagt Instagram ook echte foto's die absoluut niet met een AI-tool zijn gegenereerd. Dit maakt de betrokken fotografen boos.

Waarom dit het geval is, is nog niet helemaal duidelijk. Meta geeft weinig prijs over hoe deze tags precies worden gegenereerd. Wat wel duidelijk is, is dat het bedrijf vertrouwt op watermerken die door de AI-tools zelf in de metadata worden geschreven. Dit kan echter eenvoudig ongedaan worden gemaakt, bijvoorbeeld door in plaats daarvan een schermafbeelding van de afbeelding te uploaden.

Photoshop maakt ook gebruik van kunstmatige intelligentie technieken, bijvoorbeeld voor retoucheren of denoising. Adobe is onderdeel van de organisatie C2PA, die zich inzet voor de transparantie van creatieve content. Ik vermoed dat Photoshop in de metadata schrijft wanneer een foto met AI is bewerkt om redenen van transparantie.

Maar dat maakt een conventioneel genomen foto nog niet "Gemaakt met AI". Een foto waarop een storende plek is weggeretoucheerd met een reparatiepenseel is iets heel anders dan een afbeelding die helemaal opnieuw is gemaakt met Midjourney, Dall-E of Stable Diffusion.

Content credentials, een soort versleuteld digitaal watermerk, worden gebruikt om de authenticiteit van foto's te bewijzen en de afzonderlijke bewerkingsstappen transparant te maken. Hieronder valt ook AI-bewerking. Het doel is om volledige documentatie van het creatieproces te bieden.

Met dergelijke versleutelde metadata kunnen creatieve professionals bewijzen wat ze hebben gedaan. Maar het omgekeerde is niet mogelijk. Je kunt geen watermerken gebruiken om te bewijzen dat een foto niet echt is.

Het hele idee is gebaseerd op het feit dat de makers van de inhoud zelf geïnteresseerd zijn in transparantie. Het is niet geschikt om bedrog bloot te leggen. Maar dat is precies wat Meta wil.

Als het niet werkt met watermerken, wat werkt dan wel? Wat al vaak geprobeerd is: AI herkennen met behulp van AI. Maar dat heeft tot nu toe nog nooit gewerkt.

Professoren willen graag AI gebruiken om te controleren of een seminar paper is geschreven met behulp van een AI zoals ChatGPT. OpenAI, het bedrijf achter ChatGPT, werkte aan zo'n detector, maar stopte de ontwikkeling in 2022. De redenering is interessant: Geen enkele detector had ooit half betrouwbaar gewerkt. En blijkbaar zag Open AI geen tekenen dat dit in de nabije toekomst zou veranderen.

Deze detectoren gebruiken dezelfde methoden als generatieve AI. Beide zijn gebaseerd op machinaal leren - d.w.z. patroonherkenning op basis van grote hoeveelheden tekst als trainingsmateriaal. De detectoren bepalen hoeveel een tekst afwijkt van de stijl van een bekende AI zoals ChatGPT. Maar dit is waar de kat in de staart bijt, want ChatGPT & Co. bootsen de stijl van mensen na en zijn getraind op basis van menselijke teksten.

Er bestaat misschien zoiets als een typische ChatGPT-stijl. Maar dit is slechts de standaardinstelling, die ook kan worden gewijzigd. Deze generatoren -

of het nu tekst, beeld of muziek is - zijn erg flexibel in stijl. Ze kunnen genres nabootsen of zelfs individuen

De details zijn misschien anders voor afbeeldingen dan voor tekst. Maar het basisprobleem blijft bestaan. Een AI die wordt verondersteld betrouwbaar AI te herkennen zou veel geavanceerder moeten zijn of in ieder geval heel anders moeten werken dan de AI-tool die wordt gecontroleerd. En dat is nu juist niet het geval: patroonherkenning en patroongeneratie zijn gebaseerd op dezelfde technologie.

Zonder dat dit fundamenteel verandert, zullen we te maken blijven houden met vervelende foutieve etikettering.

Mijn belangstelling voor computers en schrijven leidde me relatief vroeg (2000) naar de technische journalistiek. Ik ben geïnteresseerd in hoe je technologie kunt gebruiken zonder gebruikt te worden. In mijn vrije tijd maak ik graag muziek waarbij ik mijn gemiddelde talent compenseer met een enorme passie.